FDI: Tecnologías de Automatización en Gaza

FUENTE: Archivo de las FDI

Lavender

categoriza a posibles objetivos humanos con una calificación de riesgo para confeccionar kill-lists

Gospel/Habsora

identifica estructuras y edificios que puedan ser objetivos

Where's daddy?

geolocaliza objetivos humanos marcados cuando vuelven a sus hogares para indicar la ideoneidad del ataque

Fire Factory

se encarga de la logística del ataque y de planificar la carga de munición

-

Depth of Wisdom

mapea los túneles subterráneos con un sensor llamado geoteléfono de Elpam Electronics, que basado en el sonido generado por el movimiento, detecta a una persona a 10 metros de profundidad.

FDI tiene datos del 90% de la población del Banco Occidental y Gaza

Blue Wolf

Aplicación móvil de escaneo facial implimentado por todo el territorio del Banco Occidental. L@s soldad@s reciben compensaciones como tiempo libre por escanear un mayor número de caras.

Red Wolf

Punto de escaneo facial en los pasos de control. Permiten o bloquean automáticamente el paso de palestin@s a través del punto de control

Mensajería y Redes Sociales

Informantes declaran que tecnologías como Lavender calculan calificaciones de riesgo basándose en contactos y grupos compartidos de WhatsApp o redes sociales como Facebook.

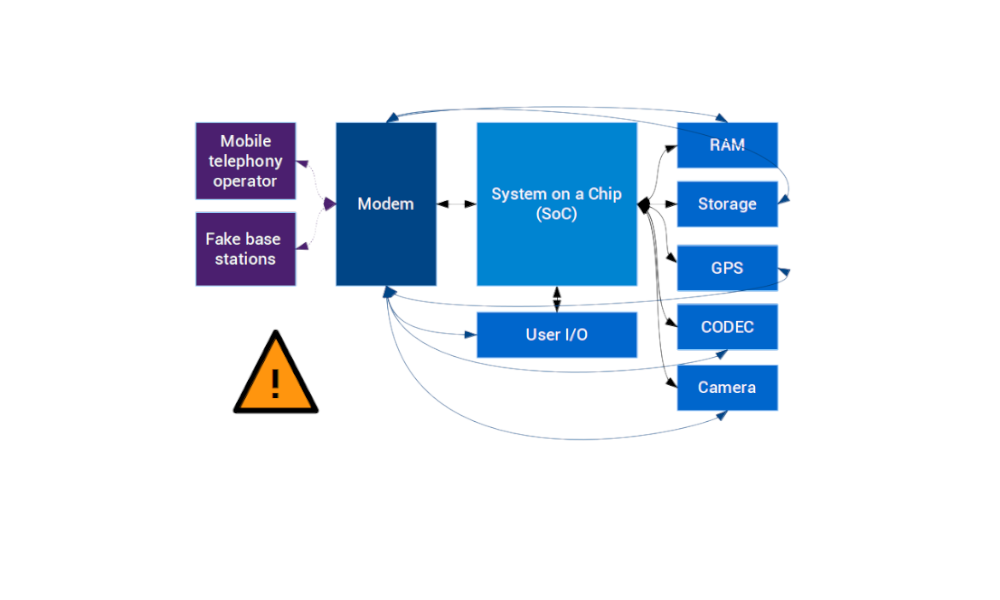

Llamadas telefónicas

IDF almacena millones de horas de llamadas en centros de datos europeos.

Geolocación y "patterns of life"

A través de datos móviles el IDF obtiene geolocaciones y "patterns of life".

Drones

Las IDF han sido pioneras en el uso de drones para vigilar a la población.

L@s palestin@s han oído noche y día los drones sobrevolar los cielos durante dos décadas.

Yossi Sariel es un oficial de las FDIs, comandante en cargo de la Unidad 8200 durante el primer año de la Guerra de Gaza.

Ha recibido premios por sus proyectos de anti-terrorismo usando IA.

La Unidad 8200 es la Unidad de Recolección de los Cuerpos de Inteligencia de las Fuerzas de Defensa de Israel cuya misión es la captación de señales de inteligencia y descifrado de códigos.

Debugging AI: Ley Humanitaria Internacional

DIH: jus in bello

El DIH es parte del derecho internacional público compuesto por tratados internacionales consuetudinarios (Artículo 38 del Estatuto de la Corte Internacional de Justicia). EL DIH regula la conducta de las partes involucradas en un conflicto armado (jus in bello) mientras que el derecho internacional público, regula el jus ad bellum.

Estas tecnologías presentan dificultades para atribuir si la responsabilidades legales del daño a civiles por un sistema autónomo (o incluso semi-autónomo), no sabiendo si tales recaen en el operador, el comandante, el programador, o el fabricante, o si la acción puede ser considerada una circunstancia ajena a su control.

Además éstas violan los siguientes principios de la LHI:

Principio de la Proporcialidad

- El sistema permite marchar hasta 100 objetivos/día aumentando la velocidad de guerra a niveles inhumanos.

Según el Teniente General Aviv Kohavi, retirado de las FDI en 2023, antes de la aplicación de tecnologías IA un analista humano producía unos 50 objetivos al año

- Se ha priorizado el uso de bombas "tontas" en un 45% de los casos.

Estas bombas conllevan un coste mucho menor, pero son bombas menos precisas que generan mayor destrucción y mayores daños colaterales.

- Informantes constatan que anteriormente no se permitían daños colaterales para operativos de Hamas de bajo rango. Ahora se permite matar hasta 20 civiles. Si el objetivo es un comandante, se permite matar más de 100 civiles.

Principio de la Distinción (entre militares y civiles)

Tanto los algoritmos, los datos, como los métodos de clasificación contienen segos que violan el principio de distinción.

- Lavender funciona con sistema "positive unlabeled learning" (PU) que facilmente produce falsos positivos, por lo que la promesa de ser preciso en un 90% es falsa.

Ejemplo: tengo 100 fotos etiquetados que sé que son gatos, và lo demás está sin etiquetar. El sistema encuentra 90 de esos 100 gatos, pero no sé si ha etiquetado 10000 perros como gatos.

- La tecnología facilita una correlación aleatoria en la que se consideran objetivos por estar en el mismo grupo de WhatsApp que alguien de Hamas, además de otros metadatos y cuestiones diversas como cambios frecuentes de número de teléfono o domicilio.

- Estos algoritmos, como muchos de los algoritmos que rigen la vida de civiles, no son de código libre por lo que son cajas negras que no se pueden auditar. No sabemos en base a qué criterios Lavender construye las calificaciones de peligrosidad.

Principio de la Humanidad

- El 50% de los objetivos atacados durante el primer mes de la guerra han sido viviendas familiares marcadas por "Where's Daddy?"

- Human in-the-loop (supervisión) validan decisiones automatizadas en 20 segundos.

- La promesa de que la tecnología ofrece una visión objetiva y más precisa del campo de batalla esconde sesgos y el inevitable "fog of war" teorizado por Clausewitz.

- Los sistemas autónomos crean una profunda crisis en el marco de la responsabilidad legal.

- La guerra se lleva a cabo de forma practicamente automatizada y basándose en los datos de una vigilancia masiva e indiscrimada de la población.